Необходимый базовый SEO софт для начинающих

Для больших проектов в поисковом продвижении лучше воспользоваться платными инструментами, которые дают существенное преимущество в производительности, однако для ясного понимания, как работает SEO можно начинать с бесплатного софта.

Работа с этим SEO софтом не потребует других затрат кроме времени на обучение и определенной усидчивости, что является большим плюсом для начинающих оптимизаторов.

Софт для составления семантического ядра

Правильное продвижение сайта нужно начинать еще на этапе его создания.

Для достижения наибольшей эффективности каждая страница сайта должна иметь определенную цель и должна быть «заточена» под соответствующие поисковые запросы.

Мы уже говорили о том, что такое семантическое ядро сайта, насколько оно важно, как грамотно его составить и как подобрать ключевые слова, а также особенности подбора ключевых слов для определенных статей, блогов или сайтов.

Для некоторых ниш можно использовать продвижение низкочастотными запросами, которое поможет добиться первых результатов сравнительно быстро.

Про способы подбора ключевых слов можно прочитать эту статью.

Можно подбирать запросы вручную, копируя фразы Яндекс Вордстата в Exel, сортируя и обрабатывая их вручную, но это может стать крайне неэффективным для проектов с большим числом ключевых слов, поэтому будем осваивать способы автоматизации.

![]()

Magadan Lite

Магадан – достаточно популярная программа в рунете для работы с ключевыми словами. Существует в двух версиях – платная Pro и бесплатная версия Lite. Работу с последней мы разберем, благо что у нее функционал почти не отличается от полной версии.

Основные возможности программы:

- сбор статистики запросов из Яндекс.Директ;

- сохранение результатов в собственных базах для дальнейшей работы;

- широкие возможности фильтров ключевых слов.

Магадан автоматизирует трудоемкие задачи парсинга ключевых слов, выкачивая целые страницы поисковых запросов вордстата. А потом он может выстроить взаимосвязь между группами запросов. Еще не существует аналогов с таким набором опций, как у этой программы.

Немного подробнее о возможностях:

- автоматизация сбора ключевых слов

- обработка точных запросов в кавычках и с восклицательными знаками перед словами

- сбор региональной статистики геозависимых запросов (только для версии Pro)

- автоматизация большого числа рутиных задач по обработке запросов: объединение, очистка и т.д.

- автоматическое добавление в очередь парсинга запросов по заданному шаблону, то есть Магадан может непрерывно работать вместо вас

- проверка запросов без захламления базы ключевых слов

- импорт/экспорт собранных запросов в файлы. Поддерживаются форматы txt, CSV/MS Excel, SQL-дамп MySQL и кодировки Win-1251, UTF-8

Порядок работы с программой таков:

- Подключить или создать новую базу ключевых слов, при этом можно задать путь сохранения базы запросов. База сохраняется в бинарных файлах собственного формата.

- Заполнить очередь запросов на парсинг, слова можно добавлять вручную или импортировать из внешнего файла.

- Из очереди «на парсинг» запросы автоматически сохраняются в подключенной ранее базе данных.

- Установить оптимальное время задержки при парсинге во избежание бана от вордстата.

- Можно задать число, ниже которого статистика не будет собираться и тогда будут отброшены слишком низкочастотные запросы, а парсинг пройдет быстрее.

- По завершению парсинга можно выделить все слова или их определенные группы в файл желаемого формата.

Ограничения версии Магадан Lite:

- Нельзя задать регионы запросов.

- Нет звукового уведомления о завершении парсинга.

- Нет автоматического добавления прокси серверов.

- Нет поддержки Antigate API.

SlovoEB

SlovoEB

Эта программа, несмотря на неблагозвучное название, считается лучшей из бесплатных для составления семантического ядра.

Несмотря на сильно урезанный функционал по сравнению с KeyCollector, у этого софта все еще остается много полезных возможностей по сбору и анализу ключевых слов.

Возможности :

- Умеет собирать все запросы статистики Яндекс Wordstat, собирает как из левой, так и с правой колонки сервиса. Без ограничений, то есть ничем не хуже, чем использовать статистику запросов Яндекса вручную.

- Сбор статистики Liveinternet с учетом популярности поисковых фраз для сбора семантического ядра.

- Определение конкурентности поисковых запросов исходя из числа сайтов в индексе по данному запросу, конкуренцию можно оценить приблизительно.

- Определение самой релевантной страницы, а это важно для правильной внутренней перелинковки сайта.

Интерфейс

Slovoeb очень похож на Key Collector, имеет интуитивно понятный интерфейс, в котором несложно разобраться.

- Панель быстрого доступа, при помощи которой начинается работа с проектами и настройками софта.

- Кнопка остановки процессов – не все задачи безупречны и в момент осознания своей ошибки процесс можно остановить.

- Стоп-слова: не все слова одинаково полезны для нашего сайта, поэтому можно добавить список исключений из поисковых запросов. Так мы сокращаем затрачиваемое время работы и отсекаем все лишнее.

- Регионы Яндекс Wordstat позволяют работать с геозависимыми поисковыми запросами – опция особенно актуальна для локальных интернет-магазинов и региональных сайтов.

- Левая колонка Yandex.WordStat – именно из нее будет выполняться пакетный сбор ключевых слов вместе с их базовыми частотностями.

- Правая колонка Yandex.Wordstat – запускает парсинг похожих запросов из правой колонки сервиса Вордстат.

- Частотности Yandex.Wordstat — существуют разные виды частотностей поисковых запросов, выпадающее меню позволяет выбрать любой из них или все. Такая опция позволяет подобрать самые эффективные ключевые слова.

Что нужно знать про частотности Яндекса:

- Базовые частотности – все запросы в любой форме;

- Частотности “ ” – только этот запрос и все его словоформы (склонениям), более длинные запросы, содержащие указанный запрос, будут отброшены.

- Частотности “!” – только точные запросы.

- Сезонность Yandex.Wordstat поможет узнать сведения о частотах поисковых запросов в разные периоды года.

- Поисковые подсказки. Для популярных запросов у популярных поисковых систем (Яндекс, Google, Mail.ru, Рамблер, Nigma и Yahoo!) можно получить поисковые подсказки, которые они обычно показывают пользователям в строке поиска.

- KEI — показатель конкуренции зависит от того, сколько сайтов в индексе Yandexи Google отвечают ключевому слову.

- Анализ релевантных страниц для конкретного сайта. Прописав адрес своего сайта, можно узнать адрес самой релевантной страницы, то есть той, которую Яндекс или Гугл считают самой авторитетной по этому запросу. То есть можно принять решение, какую страницу продвигать под тот или иной запрос.

- Указать регион нужно для более точного определения релевантности.

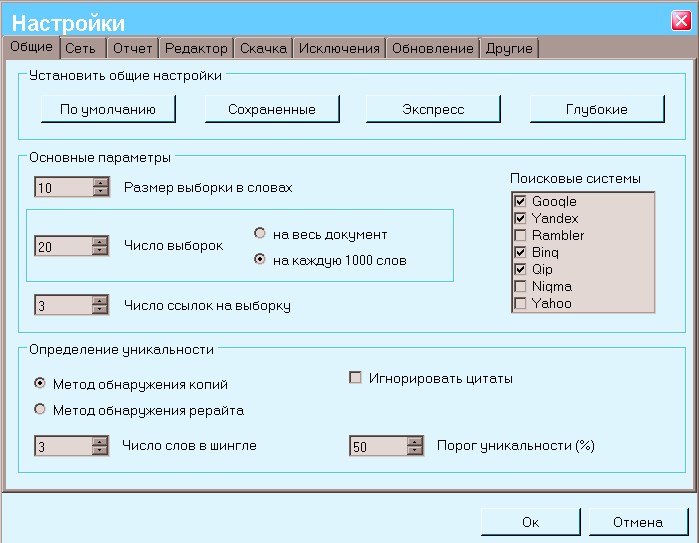

Настройка

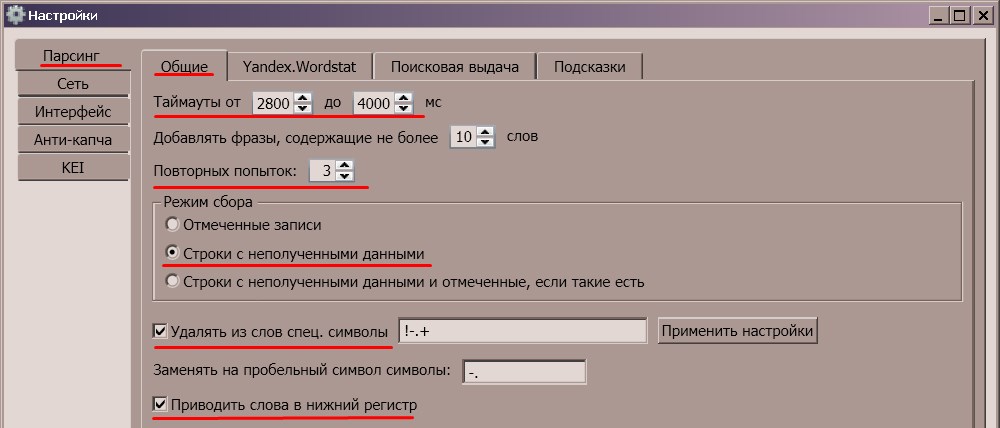

Самые важные настройки находятся во вкладке Парсинг/Общие и Парсинг/Yandex.WordStat.

Рассмотрим подробнее настройки Парсинг/Общие:

- Таймауты нужны во избежание бана IP в процессе парсинга сервисом Вордстата;

- Оптимальное число повторных попыток около 3 если возникла ошибка парсинга или Вордстат все-таки произвел временную блокировку IP, в таком случае придется использовать прокси или ждать;

- Строки с неполученными данными – собирать информацию только по тем запросам, которые еще не были полностью обработаны;

- Удалять из слов спецсимволы и приводить слова в нижний регистр — все, что нам не нужно фильтруем с помощью этих опций.

Парсинг/Yandex.WordStat:

Настроим парсинг статистики Вордстата:

- Глубина парсинга – для начала достаточно выставить в 0, если же потребуется большее значение, то не обойтись без прокси и таймаутов;

- Парсить страниц: максимальное число страниц, которые отдает сервис Вордстата – 40, а на каждой странице 50 запросов больше этого количества собрать не получится (всего до 2000 кейвордов);

- Выбор базовой частотности, по которой будет вестись парсинг зависит от конкурентности темы и того, насколько частотные запросы нам понадобятся. Для узкой ниши можно поставить от 30, а для широкой от 50-200. Верхнее значение поможет отсечь высокочастотники, если нам нужно продвижение только по НЧ запросам.

- Количество потоков – поставить не слишком много, чтобы не вызвать подозрений Вордстата, начать можно с 1;

- Виды частотностей – ставим те, которые нам нужны. Обычно для сбора семантического ядра достаточно базовой и точной(“!”) частотности. Частотности “кавычки” можно не использовать.

Парсинг

Для пасинга кейвордов пройдем через следующие стадии:

- Создать новый проект (или открыть готовый).

- Указать стоп-слова. Убираем все лишнее – для коммерческих запросов не нужны кейворды “бесплатно”, “скачать”, “приму в дар” и т.д

- Выбрать регион продвижения. Зависит от стратегии продвижения сайта. Если он содержит большое число геозависимых запросов, то лучше собирать статистику по конкретному региону.

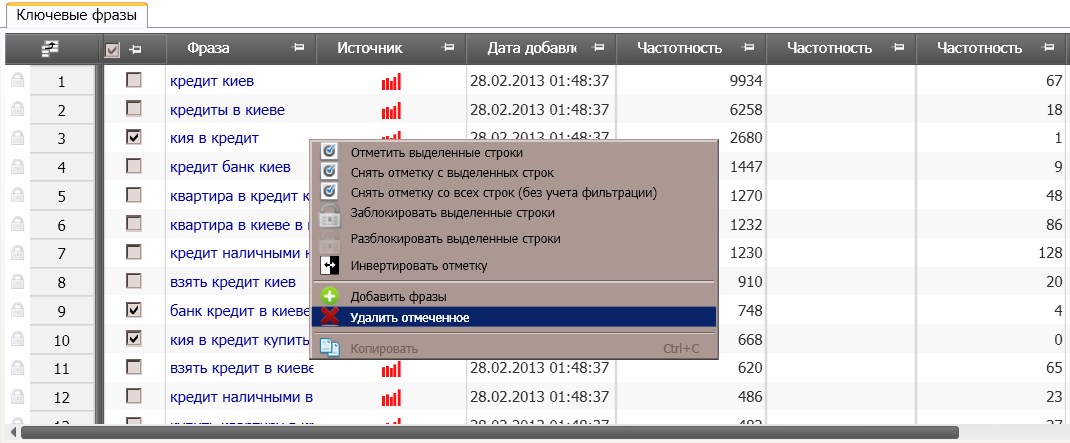

- Отобрать полученные запросы – просматриваем и убираем все неподходящие для нашего сайта фразы. Не нужно брать все подряд для составления семантического ядра сайта. Лишние ключевые слова никак не помогут в продвижении сайта, а лишь все усложнят и запутают. К отбору ключевых слов нужно подойти осмысленно, а не механически. Все ненужное выделяем и удаляем с помощью выпадающего меню (вызывается кликом правой кнопки мыши). Так мы получим список соответствующих запросов с их базовыми частотностями.

- Собрать частотности «!» и удалить слова-пустышки. Собираем значения точных частотностей и удаляем те слова, у которых это значение слишком мало — от 0 до 2. Это и есть бесполезные слова-пустышки, которые нужно отсеять.

Дополнительно можно еще сделать такие шаги:

- Узнать конкуренцию KEI и отобрать подходящие слова

- Определить релевантные страницы по самым важным ключевым запросам

- Экспортировать результаты в файл.

Вот так производится весь процесс сбора ключевых слов из левой колонки Вордстата. Нужно расширить тематику? Тогда все эти шаги можно выполнить и для правой колонки Yandex.Wordstat.

Анализ и составление семантического ядра

Затем нам нужно узнать конкуренцию по ключевым словам. Для этого можно использовать возможности программы Slovoeb и получить число конкурирующих сайтов по этим запросам.

Но для получения большего количества и качества данных можно воспользоваться возможностями seo-агрегаторов. Например, полученные запросы можно добавить в ссылочные агрегаторы SeoPult или ROOKEE и узнать их стоимость продвижения.

Проведя подсчеты в программе Excel, можно принять решение, какие запросы мы будем продвигать.

Тщательный анализ полученных ключевых слов поможет построить из них семантическое ядро сайта.

Итак, эта программа прекрасно справляется со своими задачами и освоить ее не так сложно, как кажется на первый взгляд.

Работа с контентом сайта

Поисковые системы постоянно повышают требования качества к сайтам, особенно к новым проектам. Одним из алгоритмов, определяющих качество сайтов, является проверка контента на уникальность. Контентом сайта является все его содержимое, которое может быть проиндексировано – это тексты, графика, видео и другие web объекты.

Контент на сайте должен быть полезным для людей, предоставлять ценную информацию, товары или услуги. Если сайт выгодно отличается от своих конкурентов, содержит уникальные статьи и картинки, то при прочих равных условиях он будет ранжироваться выше других.

Следует учитывать, что одной уникальности мало, контент не должен быть автоматически генерированным, а сайт не должен вводить в заблуждение ни посетителей, ни поисковые системы.

В зависимости от тяжести нарушений такой сайт рискует попасть под санкции поисковых систем: попасть под фильтры, полностью выпасть из индекса поисковой системы и даже уйти в бан. В случае бана сайт становится запрещенным для индексации.

Поэтому для успешного развития сайта потребуется наполнять его уникальными статьями, так как плагиаторов поисковые системы не любят.

Advego Plagiatus и Etxt Антиплагиат

Для проверки статей на уникальность существует специальный софт: Advego Plagiatus (Адвего плагиатус) от биржи статей Advego и Etxt Антиплагиат от etxt.ru

Эти программы проверяют на уникальность статьи, у них сходный принцип действия, хотя при своей работе они могут выдавать несколько отличающиеся результаты. Если позволяют возможности, то лучше проверять статьи на уникальность этими двумя программами, хотя обычно пользуются каким-то одним инструментом.

Не будем подробно углубляться в особенности работы поисковых систем по определению уникальности текста. Скажем лишь, что есть такое понятие как шингл («черепица», «кирпичик», «ячейка») – это последовательность нескольких слов в определенном порядке. По этой последовательности и определяется уникальность статьи.

Если вы хотите покупать статьи или заказывать их у копирайтеров, то проверять их работу вы можете с помощью этих программ, ведь хорошая статья должна быть не только информативной и полезной, но и быть достаточно уникальной и не содержать в себе плагиата.

Само собой разумеется, что трудно выдумать что-то свое и каждая статья, которая технически не является плагиатом, логически остается модифицированной последовательностью заимствованных идей у других авторов. Но вся журналистика стоит на заимствовании друг у друга информации, его анализе и синтезе.

Нужно хорошо разбираться в тематике сайта, так чтобы при добавлении новых статей не пострадала их достоверность, а сайт нес актуальную и качественную информацию. Требования к качеству контента у сайтов разного назначения отличаются и чем они выше, тем больший понадобится бюджет.

Статья в тему: 3 способа защитить контент от копирования.

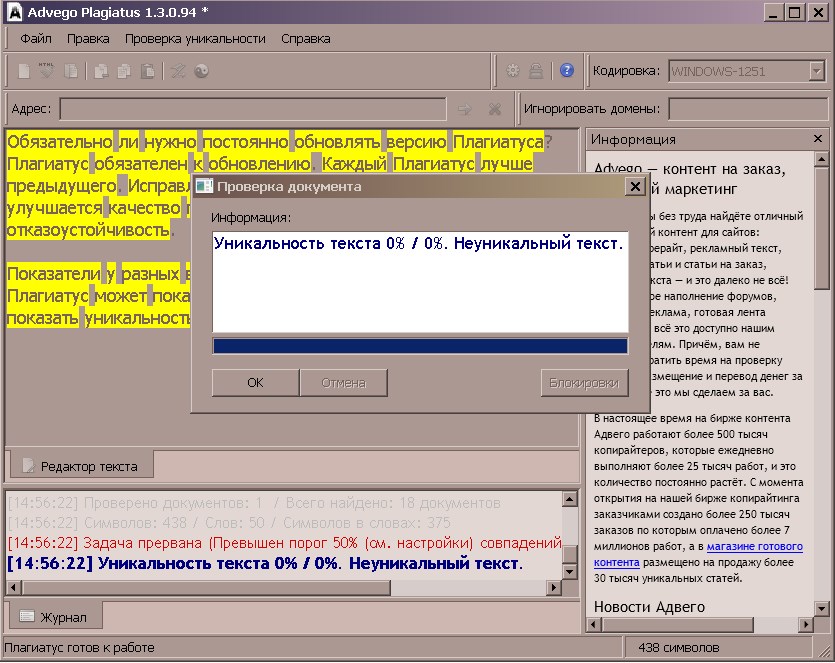

Advego Plagiatus

Итак, рассмотрим программу Advego Plagiatus. При ее запуске мы должны проверить наличие обновлений, потому что только последняя версия гарантирует достоверность результатов: что-то может поменяться в алгоритме программы и, если мы пользуемся старой версией, то в некоторых случаях она может выдавать уникальную статью за плагиат или наоборот – она может копипаст (скопированный контент) считать уникальным.

В текстовое поле этой программы мы вставляем текст статьи и запускаем проверку. Скорее всего, программа у нас потребует распознавание русской каптчи, что не очень удобно при проверке большого количество статей. Поисковые системы требуют от нас подтвердить, что за компьютером сидит человек, а не бот отсылает им запросы.

Однако в настройках программы можно указать аккаунт сервиса для распознавания каптчи, услуги этих сервисов стоят совсем недорого, но при этом позволяют экономить драгоценное время.

После того как произошла проверка, программа показывает нам результаты: она ищет совпадающие фрагменты текста и показывает ссылки на те страницы сайтов, на которых был обнаружен похожий текст. Затем она суммирует уникальность статьи и показывает нам результат, будь то рерайт или копирайт. В идеале должна быть стопроцентная уникальность статьи, но для некоторых текстов, особенно технических, этого добиться достаточно трудно, тем более, если тема статьи распространена и по ней опубликовано достаточно много материалов.

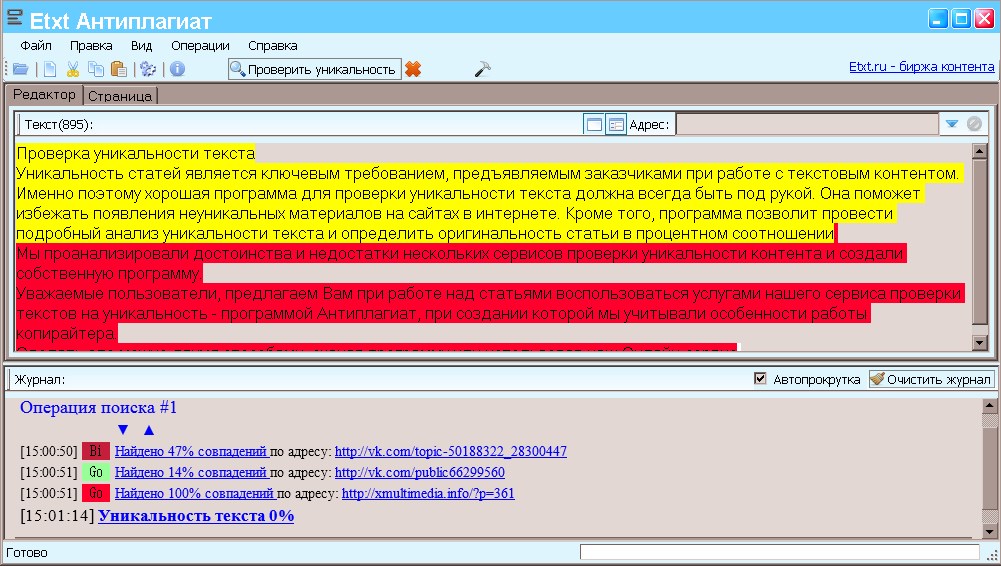

Etxt Антиплагиат

Подробно рассмотрев работу адвего плагиатуса, мы отметим, что Etxt Антиплагиат работает аналогичным образом. Если мы проверили уникальность текста в обеих программах, то мы можем быть уверены в достоверности результатов.

Однако эта программа имеет свои преимущества:

- Может выполнять пакетную проверку файлов на диске

- Сканировать сайт и проверять на уникальность все его страницы, создавать подробный отчет

- Работать со списком прокси серверов

- Распознавать капчи поисковиков

- Вести историю проверок

Как видим, функционал Etxt Антиплагиат намного мощнее, чем Advego Plagiatus.

Проверка позиций и аудит сайта

Самый простой и успешный путь правильного развития своего проекта при отсутствии достаточного опыта – это научиться у конкурентов.

А для успешной и эффективной SEO разведки нам понадобятся программы, которые помогут выполнить аудит сайтов конкурентов и разобраться, почему же они занимают те или иные позиции выдачи по определенным запросам.

Кроме того, эти же программы нам понадобятся в процессе работы над собственным сайтом, поскольку создание более-менее серьезного проекта в настоящее время это не вопрос одного дня. Это может занимать достаточно длительное время и на сайте будет постоянно идти развитие. За всем эти процессом нужно следить и анализировать, не допустили ли мы ошибок, которые могут нам существенно помешать процессу поискового продвижения сайта.

![]()

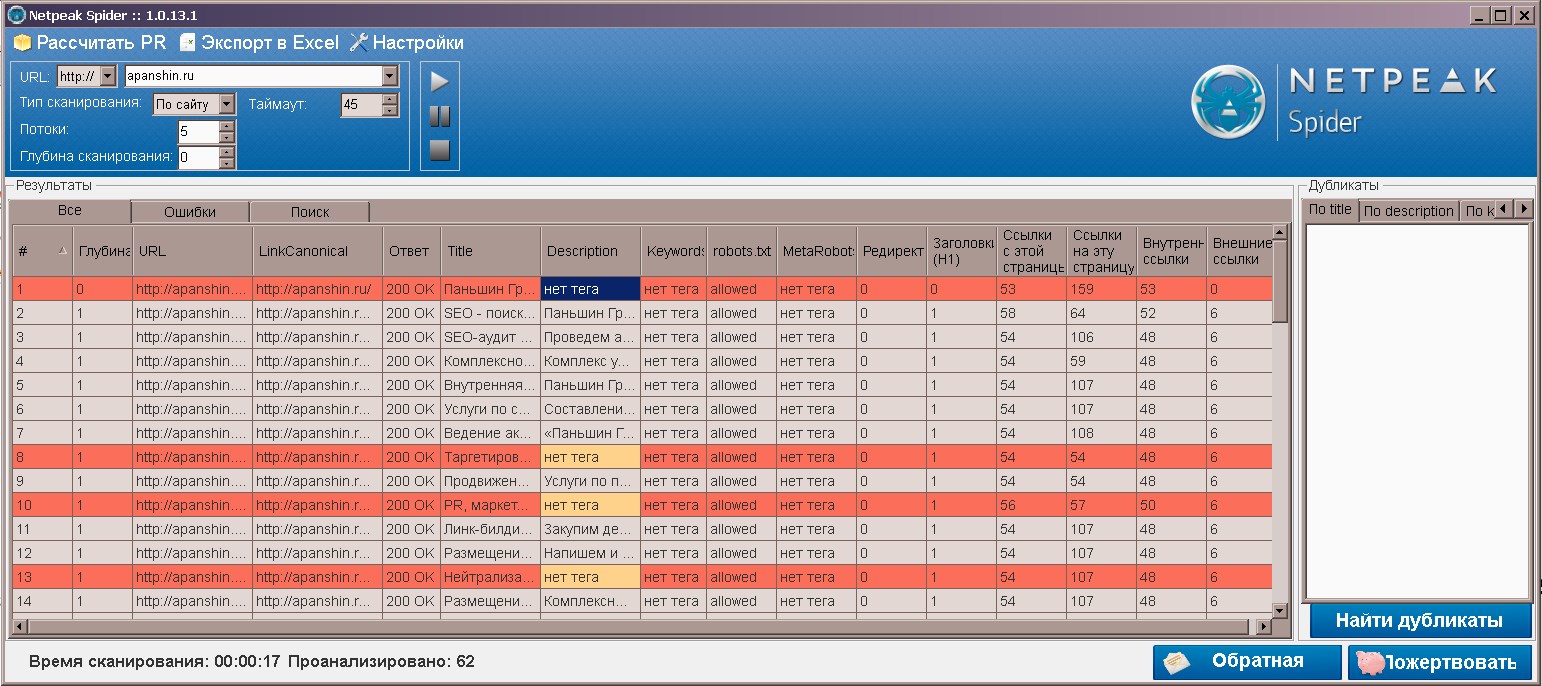

Netpeak Spider

Netpeak Spider — бесплатная программа для анализа сайта. Производит сканирование, используя собственного бота, похожего по алгоритму работы на ботов поисковых систем.

Проверяет параметры сайта и анализирует их, предоставляет нам такие возможности:

- Помогает находить ошибки, неправильные редиректы, битые ссылки, дубликаты заголовков страниц (title), описания(description), ключевых слов (keywords)

- Анализ всех ссылок для каждой станицы сайта (исходящих и входящих)

- Оценка веса каждой станицы (по GooglePageRank)

- Множество опций сканирования и анализ работы robots.txt

- Выгрузка результатов работы в формат Excel

Сначала вводим адрес сайта, который будем анализировать:

Количество потоков программы и таймауты позволят выбрать оптимальный режим работы между скоростью анализа и нагрузкой на хостинг сайта.

Настроим необходимые опции:

Linkcanonical – указывает адрес предпочитаемой страницы (если есть дубли страниц, то одна из них должна быть или закрыта от индексации или на другой должен быть тег “rel=canonical”).

Ответ – можно проверить ошибки сервера, корректно ли он обрабатывает страницы сайта.

Title – желательно прописывать вручную или с помощью специальных плагинов, не должен быть генерированным (содержать осмысленный текст).

Теги Description и Keywords: отображает, прописаны ли теги. Некоторые считают, что они устарели, а их отсутствие не является критической ошибкой, однако их наличие повышает качество сайта в глазах поисковых систем. Не рекомендуется злоупотреблять тегами: перегружать их повторяющимися ключевыми словами или вводить посетителей в заблуждение неправильными description (описание станицы в сниппете поисковой выдачи).

Если мы сканировали роботс, то у нас доступна колонка robots.txt, таким образом мы можем видеть как работают правила robots.txt.

Редиректы нужно учитывать, особенно, если на эти страницы проставлены ссылки

Каждая страница должна содержать один заголовок H1 как можно ближе к ее началу.

В поисковом продвижении важную роль играют ссылки, даже если говорят об их «отмене», но другой альтернативы у поисковых алгоритмов нет.

Ссылки с этой страницы (внутренние ссылки + внешние ссылки) передают некоторый вес, при этом он может «утекать», то есть сама страница теряет некоторую часть веса. Тут нужно обратить внимание на внешние ссылки. Считается, что много внешних ссылок – это плохо, если внешних ссылок больше 100, то можно попасть под фильтр за ссылочный спам.

Внутренние ссылки — наоборот являются показателем перелинковки сайта, но у нее тоже есть свои особенности, которые нужно соблюдать.

Ссылки на эту страницу – можно посмотреть и проанализировать ссылки собственного сайта на эту страницу. Для просмотра ссылок с других сайтов нужно воспользоваться специальными сервисами, например Ahrefs.

В правой колонке – найти дубликаты

Как правило, дубликатами будут страницы пагинации и архивов, это нормально если они закрыты от индексации средствами CMS или robots.txt. Если же видим обычную страницу – дубликат, то на это следует обратить особое внимание.

Обычно это может быть страница комментария.

Экспорт в Exel может включать в себя результаты и дубликаты.

Настроим экспорт и сохраним результаты:

Ограничения: не рекомендуется использовать для сайтов, у которых больше 500 000 страниц.

Кодировка берется из заголовков или мета-тегов, если не задать ее автоматически.

![]()

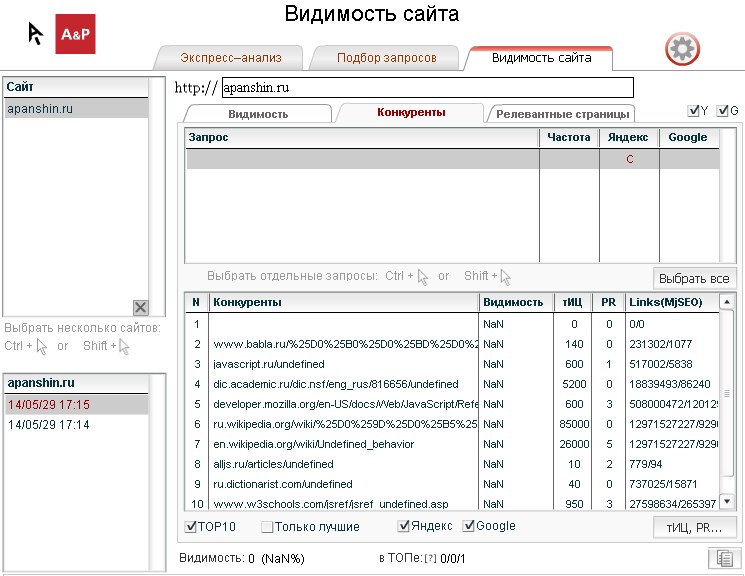

Site-Auditor

Site-Auditor – это отличная программа для определения позиций сайта, тИЦ, Pr, Alexa Rank и прочих показателей, проверка параметров осуществляется достаточно быстро. Поэтому с ее помощью можно следить не только за своими сайтами, но и просмотреть сайты конкурентов, что может помочь в продвижении сайта.

Программа предоставляет возможности узнать:

- Позиции сайта в поисковых системах по ключевым словам

- ТИЦ и Google PageRank

- Индексация сайта в разных ПС

- Наличие сайта в популярных каталогах: Яндекс, Рамблер, Mail.ru, Dmoz, Yahoo!

- Статистика посещения сайта с различных сервисов и другие показатели.

Собранная информация сохраняется на диск, так что можно отследить историю развития сайта.

Множество значений, которые помогает определить эта программа кликабельны и по этим ссылкам можно получить достаточно много дополнительной информации.

Сразу после открытия программы в адресную строку можно написать название своего сайта и выполнить экспресс анализ.

Чаще всего в этой программой удобно пользоваться для проверки позиций сайта. Это сделать совсем просто: добавим список основных ключевых слов, по которым продвигается сайт и нажимаем кнопку проверить. Естественно, на этом сайте должны быть статьи с этими ключевыми словами.

Отслеживая основные позиции вашего сайта по определенным запросам, можно следить, как продвигается сайт, какие страницы продвигаются наиболее удачно и как обогнать конкурентов.

Итак, для проверки позиций переходим на вкладку «Подбор запросов» и вставляем в текстовое поле список ключевых слов, нажимаем «Скопировать» (справа от поля кнопка с текстом и стрелкой). Программа перебросит запросы на вкладку «Видимость сайта» нажимаем кнопку «Проверить». Яндекс может запросить капчу, что не очень удобно, но через некоторое время нам будут показаны позиции нашего сайта.

Позиции кликабельны и при нажатии открывается браузер с поисковой выдачей по этому слову.

Стоит отметить, что эта программа также позволяет отслеживать обратные ссылки и посещаемость сайта. Чем больше качественных обратных ссылок на наш сайт поставлено, тем лучшие позиции он может занять при условии соблюдений правил линкбилдинга.

Также программа позволяет просмотреть, какие счетчики установлены на сайте перейти к их статистике, если она доступна для нас.

![]()

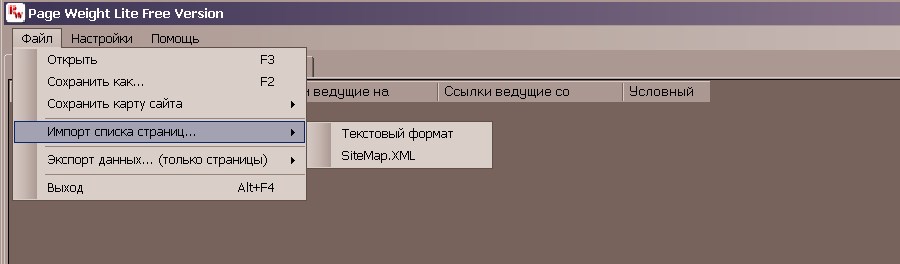

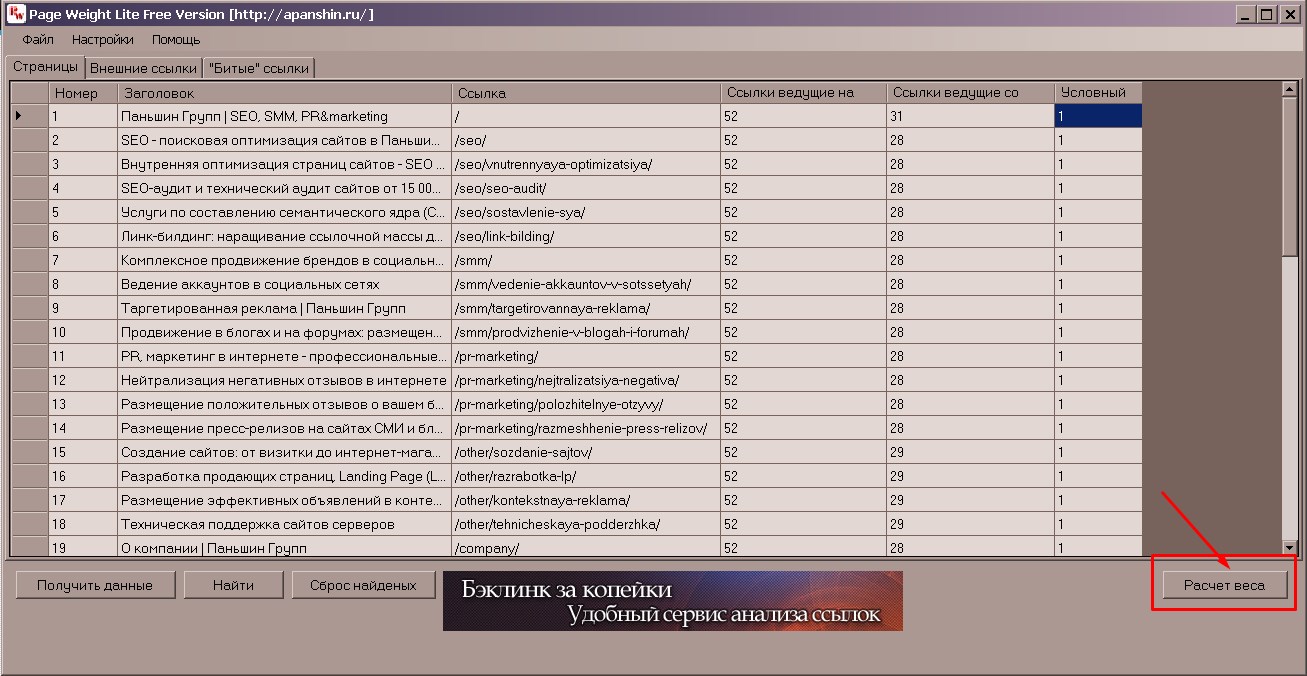

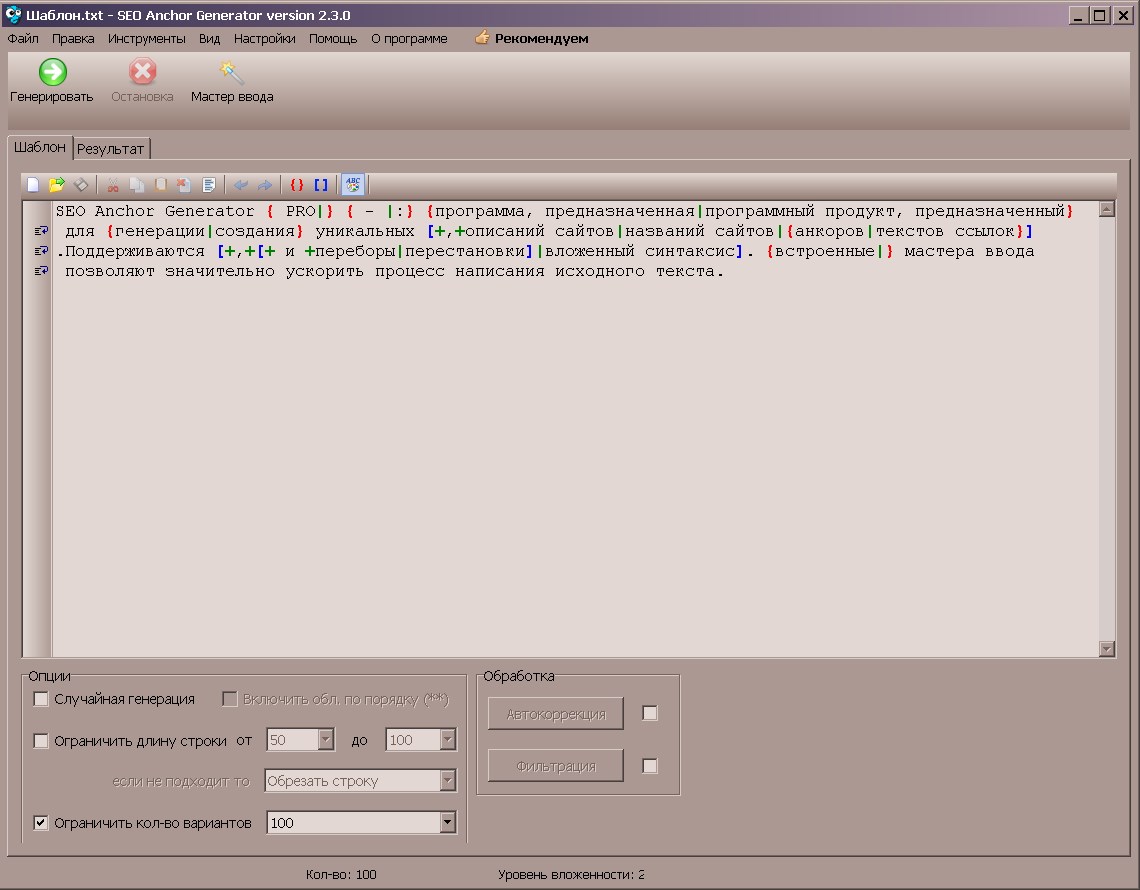

Page Weight Lite

Page Weight Lite – этот софт предназначен для вычисления веса страниц сайта. Программа достаточно проста и в то же время функциональна.

Разберем ее сильные и слабые стороны с позиции SEO.

Ограничения программы:

- Если сайт очень большой, а хостинг дешевый и слабый, то получение данных займет много времени;

- Этот софт не отображает, на каких именно страницах находятся внешние ссылки;

- Скромный набор опций бесплатной программы. Тут не приходится ожидать богатого функционала вроде наглядной визуализации передачи веса между страницами.

Возможности:

- Устанавливать время задержки между запросами – полезно, если хостинг слабый;

- Выбрать, учитывать ли атрибуты rel=nofollow, теги noindex, и файл robots.txt;

- Указать User-agent: PageWeight, что позволит фильтровать статистику, чтобы не портить отчеты в системе аналитики;

- Обнаружить битые ссылки, по которым вес страницы уходит в никуда и там исчезает (для сайтов на WordPress существует плагин Broken Link Checker, который выполняет эту же задачу и присылает на почту отчеты о проблемах);

- Указать несколько итераций для получения более точных данных расчёта весов;

- Экспортировать результаты работы программы в файл формата CSV, поддерживается также экспорт XML- и HTML-карты сайта;

- Загрузить XML-карту сайта, для расчета веса конкретных страниц сайта.

Разберем работу программы по порядку.

- Ипортируем список страниц

- В следующем окне прописываем список интересующих страниц относительно основного Url:

Слеш означает корень сайта, то есть в данном случае сканировать весь сайт. Жмем кнопку ОК и затем «Получить данные» — кнопа внизу слева.

- Получаем данные о странице или сайте:

Досадно, что кнопку «Расчет веса» можно пропустить и потом ругать эту программу, потому что эта кнопка прячется в правом нижнем углу и в некоторых состояниях окна она вовсе не видна, поэтому окно нужно развернуть пошире.

- Рассчитаем вес страниц и укажем количество итераций, чем больше, тем точнее результат, но это потребует больше времени:

После расчета видим такую картину:

Следует учесть, что условный вес не имеет никакого отношения к Google PageRank.

Практическая польза от этой программы в том, что она поможет существенно сохранить бюджет при покупках «вечных» ссылок и статей. Хитрые доноры делают жесткую перелинковку своих сайтов, поэтому вес таких ссылок передается очень слабо. И мы получим от такого сайта эффект значительно меньший, чем ожидалось. Поэтому перед закупкой ссылок проверяйте сайты-доноры этой программой.

![]()

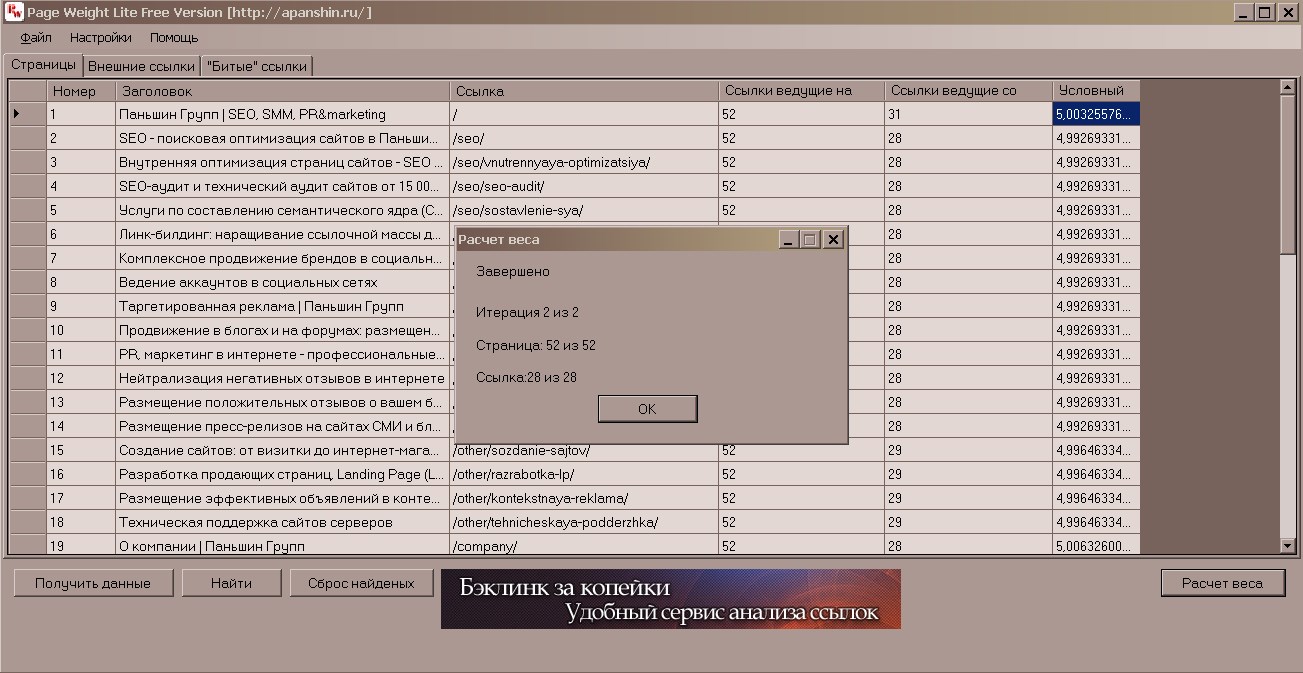

SiteMapGenerator

Если файл robots.txt закрывает страницы и раздела для индексации роботами поисковых систем, то карта сайта наоборот – позволяет установить приоритет индексации определенных страниц и разделов сайта. Карта сайта существует в двух вариантах: для людей – в HTML формате и для ботов в XML.

- Многие современные CMS типа WordPress способны создать карту сайта с помощью специальных плагинов.

- Если сайт реализован на CMS, у которой нет собственных средств для создания карты сайта, то лучше будет воспользоваться данным софтом.

- Программа SiteMapGeneratorбудет особо актуальна для сайтов с большим количеством страниц и сложной структурой.

Наша статья о создании карты сайта.

Функционал программы:

- Выбор главной страницы сайта;

- Исключение лишних страниц из карты сайта или наоборот – включение только некоторых;

- Создание карты сайта в нескольких форматах – GoogleSiteMap/XML, YahooMap/Text, Html, CSV

- Просмотр robots.txt – в нем должен быть прописан путь к карте сайта

- Проверка некорректных URLна сайте

- Многопоточность сканирования сайта

Интерфейс программы на английском языке, однако она очень проста: все что нужно ввести адрес сайта (ExtractLinksFromSite), установить максимальное число потоков (Max. SimultaneousConnection) и при необходимости прописать страницы (главная StartPages, шаблоны исключений ExcludePatterns или те, которые нужно включить в карту Must-FollowPatterns).

StartPages: если главная страница не стандартная index.php, то в первой колонке указываем ее адрес.

ExcludePatternsи Must-FollowPatterns имеют простые правила синтаксиса

*seo/* — все страницы раздела seo

*seo* — адреса страниц содержат seo.

Вот пример генерации сайта без указания каких-либо параметров:

В итоге мы получим карту сайта в любом из нужных нам форматов:

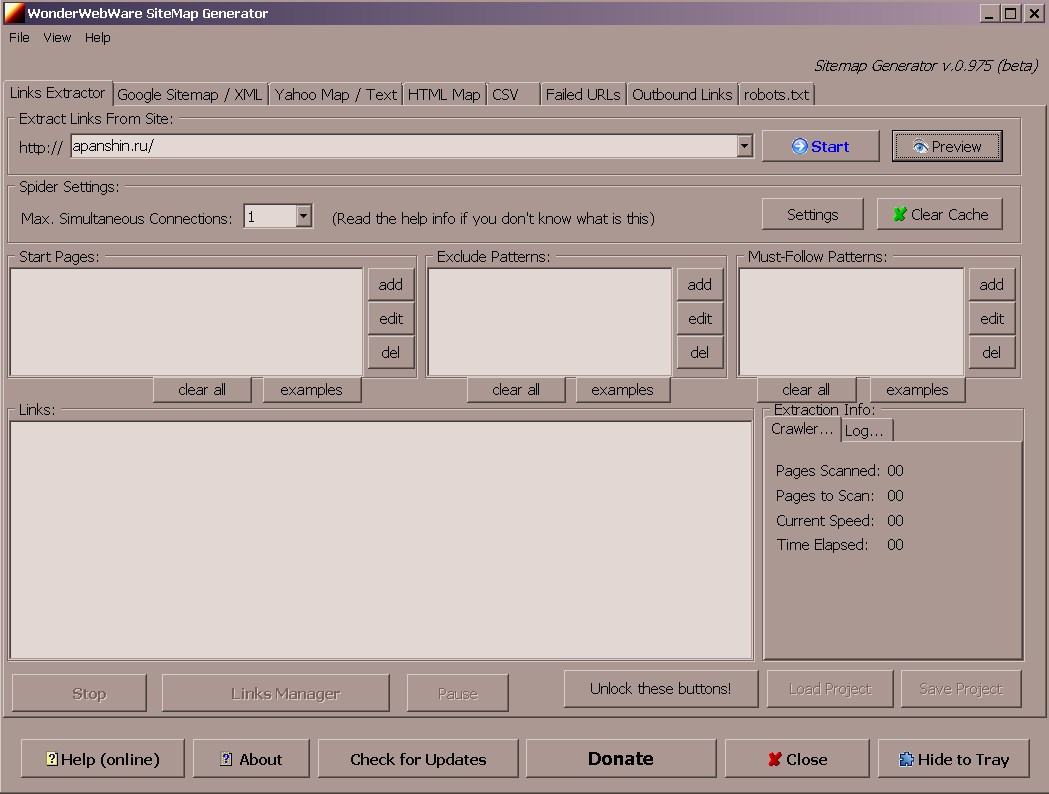

SEO Anchor Generator

Для успешного линкбилдинга (наращивания ссылочной массы сайта) используются как методы анкорного так и безанкорное продвижение (то есть с использованием в ссылках анкоров или url продвигаемых страниц).

Анкор (англ. якорь) – это текст гиперссылки, который виден посетителю сайта, на котором есть эта ссылка и если она интересна, то пользователь может перейти на наш сайт. Этот текст находится между html-тегами <a> и </a>. Если на страницу ведут только лишь ссылки с анкорами без особой семантической нагрузки типа «здесь», «тут», «вот», «там», «еще» и подобные им естественные анкоры, то это не очень хорошо. Дело в том, что поисковые системы учитывают текст анкора ссылки и околоссылочный текст при ранжировании сайта по тому или иному запросу. То есть правильно подобранные анкоры помогают добиться наибольшего эффекта от ссылок, ведущих на наш сайт.

Вся совокупность анкоров ссылок, ведущих на страницу называется анкор-лист, который:

- составляется поисковыми системами при учете всех ссылок на страницу;

- должен быть разнообразным, так как ссылки с одинаковыми анкорами могут склеиться поисковиками, и тогда они будут передавать меньше веса;

- рекомендуется разбавлять добавлением к поисковым запросам прилагательных, синонимов и т.д.;

- чем больше нужно ссылок, тем разнообразнее должны быть их анкоры;

- должен быть читабельным и понятным для человека;

- не должен быть похож на автоматически сгенерированный спам.

Кроме того, при безанкорном продвижении околоссылочный текст также попадает в анкор-лист.

Итак, если нам нужно продвинуть десять страниц сайта по пять конкурентных запросов и каждому запросу нужно всего 20-30 ссылок, то нам нужно составить 1000-1500 уникальных анкоров! На практике же задачи по продвижению требуют намного большего объема работы.

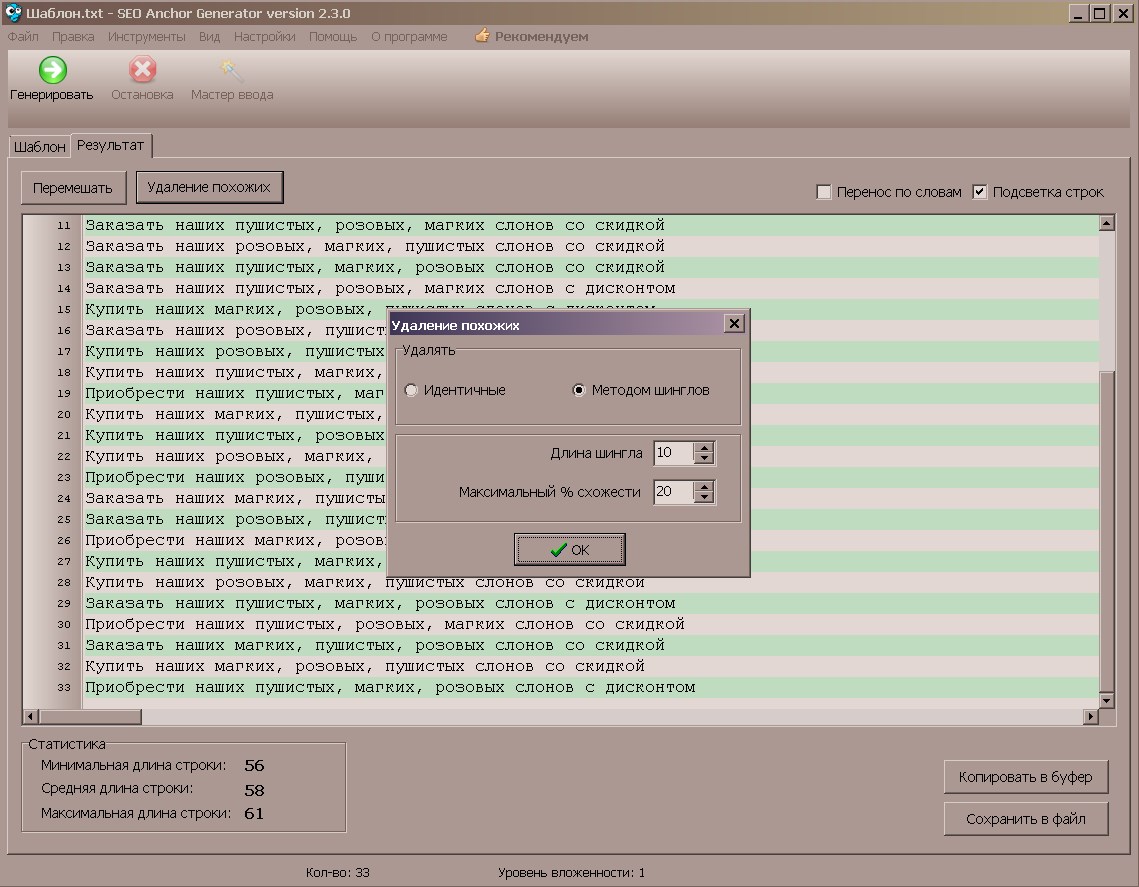

Чтобы облегчить этот нелегкий труд, нам на помощь приходит программа SEO Anchor Generator, которую мы будем использовать для автоматизации этой работы.

Синтаксис составления шаблонов генерации текста таков:

{a|b|c|d} – в тексте будет одно из слов;

[a|b|c|d] – все слова в случайном порядке, но здесь нужно ставить пробелы или после или перед словами, чтобы они не слились или использовать разделитель пробел — [+ +a|b|c|d], запятую — [+,+a|b|c|d] или другой.

- Поддерживаются вложенные конструкции, что значительно увеличивает возможности программы.

Например такая конструкция [+ — +[+, +a|b|c]|[+, +d|e|f]] дает 52 варианта выражений.

Пример анкора для интернет магазина мягких игрушек может быть таким:

{Купить|Заказать|Приобрести} наших [+, +розовых|пушистых|мягких] слонов {с дисконтом|со скидкой}, после удаления похожих дает 33 варианта анкоров.

- В программе присутствует мастер ввода, который значительно облегчает составление шаблона генерации.

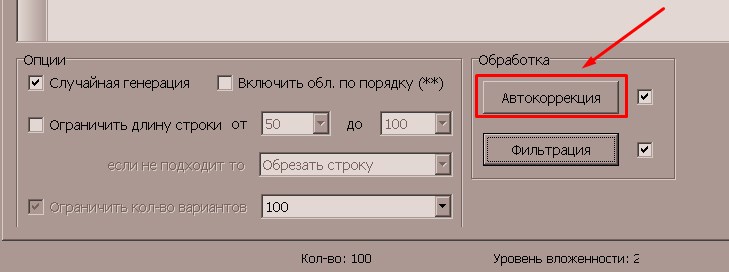

В настройках программы присутствует пост-обработка, которая помогает исправить типичные ошибки, которые обычно возникают при небрежном составлении шаблонов генерации текста (проблемы заглавных букв в начале предложения и лишних или отсутствующих пробелов).

- Но для того, чтобы эти правила сработали, не забудьте включить автокоррекцию в опциях.

Итог

Таким образом мы видим, что каждый желающий заниматься продвижением сайтов может начинать осваивать бесплатный SEO софт, который поможет ему приобрести навыки поисковой оптимизации.

Однако освоение этих навыков требует достаточно много времени и усилий.

Нам интересно, а каким софтом пользуетесь вы? Ждем ваших ответов в комментариях.

SlovoEB

SlovoEB